俄罗斯方块揭示了人们如何应对不公平的人工智能

一项实验显示,两个人玩俄罗斯方块的修改版(有40年历史的积木堆叠视频游戏),结果显示,回合较少的玩家认为另一个玩家不太讨人喜欢,无论回合数是人还是算法分配回合。

“我们预计,在团队中工作的人会关心他们是否受到另一个人或人工智能的不公平对待,”康奈尔安·S·鲍尔斯计算与信息科学学院信息科学副教授Malte Jung说。

大多数关于算法公平性的研究都集中在算法或决策本身上,但荣格试图探索受决策影响的人之间的关系。

“我们开始看到很多情况,在这种情况下,人工智能决定如何在人们之间分配资源,”荣格说。“我们想了解这如何影响人们看待彼此和相互对待的方式。我们看到越来越多的证据表明,机器扰乱了我们彼此互动的方式。

休斯顿·B·克劳尔(Houston B. Claure)是27月<>日发表在《人类行为中的计算机》(Computers in Human Behavior)上的《机器分配行为的社会后果:公平性、人际感知和绩效》(The Social Consequences of Machine Allocation Behavior: Fairness, InterhyalPerceptions and Performance)一书的第一作者。Claure获得了机械工程硕士和博士学位,辅修计算机科学。

荣格和克劳尔进行了一项早期的研究,其中机器人选择给哪个人一个块,并研究每个人对机器分配决策的反应。

“我们注意到,每当机器人似乎更喜欢一个人时,另一个人就会感到不安,”机器人组实验室主任荣格说,“我们想进一步研究这个问题,因为我们认为,随着机器做出决定变得越来越成为世界的一部分——无论是机器人还是算法——这让人感觉如何?”

由于使用物理机器人进行实验和分析数据需要时间,Jung和Claure认为有一种更好,更有效的方法来研究这种效应。就在那时,俄罗斯方块——最初于 1984 年发布,长期以来一直是希望获得有关人类认知、社会行为和记忆的基本见解的研究人员的有用工具——进入了画面。

“在资源分配方面,”克劳尔说,“事实证明,俄罗斯方块不仅仅是一个游戏 - 它是一个强大的工具,可以深入了解资源分配,绩效和社会动态之间的复杂关系。

Claure(现在是耶鲁大学的博士后研究员)使用开源软件开发了俄罗斯方块的双人版本,玩家在其中操纵掉落的几何方块,以便在积木堆积到屏幕顶部之前堆叠它们而不会留下间隙。克劳尔的版本,共同俄罗斯方块,允许两个人(一次一个)一起工作完成每一轮。

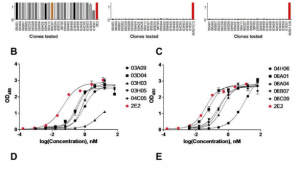

一个“分配器”——无论是人类还是人工智能,传达给玩家——决定了每个回合哪个玩家。荣格和克劳尔设计了他们的实验,以便玩家拥有90%的回合(“更多”条件),10%(“更少”)或50%(“相等”)。

研究人员发现,可以预见的是,那些轮到较少的人敏锐地意识到他们的伴侣得到了更多的转弯。但他们惊讶地发现,无论是人类还是人工智能在分配,对它的感觉都大致相同。

一个特别有趣的发现:当分配由AI完成时,接受更多回合的玩家认为他们的伴侣不那么占主导地位,但是当分配由人类完成时,对支配力的感知不会受到影响。

这些决策的影响就是研究人员所说的“机器分配行为”——类似于既定的“资源分配行为”现象,即人们基于分配决策表现出的可观察行为。荣格说,机器分配行为是“一种概念,即机器决定如何分配某些东西会产生这种独特的行为。

研究人员还发现,公平性并不会自动带来更好的游戏玩法和性能。事实上,平均而言,平均而言,平均分配回合数的得分比不均分配差。

“如果一个强大的球员得到大部分的盖帽,”克劳尔说,“球队会做得更好。如果一个人得到90%,最终他们会比两个普通玩家分开块更好。

信息科学助理教授(Cornell Bowers CIS)和该研究的合著者Rene Kizilcec希望这项工作能够引发更多关于人工智能决策对人的影响的研究,特别是在人工智能系统做出连续决策的情况下,而不仅仅是一次性选择。

“像ChatGPT这样的人工智能工具越来越多地嵌入到我们的日常生活中,随着时间的推移,人们会与这些工具建立关系,”Kizilcec说,“例如,教师、学生和家长如何根据他们在数周和数月的互动来思考人工智能导师的能力和公平性非常重要。

另一位合著者是Seyun Kim,他是卡内基梅隆大学人机交互的博士生。

免责声明:本文为转载,非本网原创内容,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。